HBM4持续加速:AI时代竞争新焦点

近日,标准组织JEDEC固态技术协会公布了新一代的高带宽内存HBM4的标准制定即将完成。HBM4是目前发布的HBM3标准的进化版,旨在进一步提高数据处理速率,同时保持基本特性,例如更高的带宽、更低功耗和更大的每个芯片和/或堆栈容量 —— 这些对于需要高效处理大数据集和复杂计算的应用至关重要,包括生成人工智能(AI)、高性能计算、高端显卡和服务器。

算力性能发挥的关键

随着人工智能领域的蓬勃发展,大模型参数量呈现指数级增长。算力越强每秒处理数据的速度越快,带宽越大每秒可访问的数据越多,算力强弱主要由AI芯片决定,而带宽由存储器决定,存力是限制AI芯片性能的瓶颈之一。AI芯片引发了对与之匹配的内存系统进行升级的迫切需求,需要高带宽、低能耗,同时在不占用面积的情况下可以扩展容量的存储器。

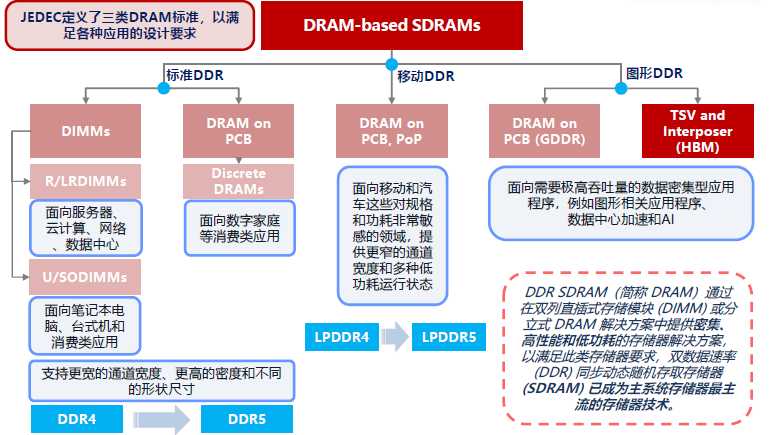

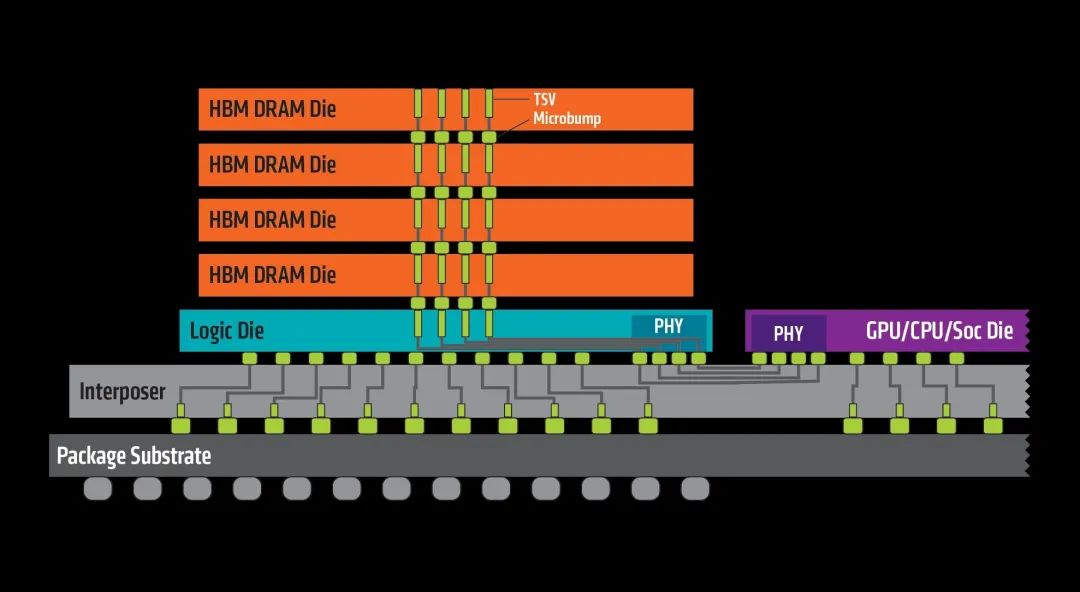

内存系统从微观到宏观可划分为存储单元、阵列、die、封装、系统等五个层级。不同DRAM标准如DDR、LPDDR、GDDR、HBM等采用不同的封装形式,如LPDDR和GDDR常将1至多个die直接安装于主板PCB上,而DDR则多采用DIMM模块插入主板插槽。HBM则独树一帜采用垂直堆叠封装,意味着在同一物理空间内可以容纳更多的内存单元,通过TSV技术实现die间互连,借助CoWoS技术与处理器高效通信,拥有远超其他DRAM的带宽。

HBM凭借堆叠结构和垂直TSV互连技术,具备高带宽、高存储密度、低功耗和紧凑尺寸等优势,尤其在AI和HPC应用中,其高带宽对大模型训练和推理效率的提升至关重要。但高于普通DRAM数倍的价格,使得对HBM一直都是“名气没输过、销售没赢过”的独特存在,AI大模型的出现让HBM找到完美的应用场景。

HBM(HighBandwidth Memory,高带宽内存)其实就是将很多个DDR芯片堆叠在一起后和GPU封装在一起,实现大容量、高位宽的DDR组合阵列,被视为新一代DRAM解决方案。当前HBM遵循相当标准的设计:内存堆栈通过微凸块连接到位于基础封装层上的中介层,微凸块连接到堆栈中的硅通孔(TSV或连接孔);中介层上还安装了一个处理器,并提供到处理器的连接。

HBM4持续加速

高带宽内存已存在约十年,从HBM1目前最新到HBM3E,迭代方向是提高容量和带宽,容量可以通过堆叠层数或增加单层容量获得提升,带宽提升主要是通过提升I/O速度。但随着内存传输速率的提高,尤其是在DRAM单元的基本物理特性没有改变的情况下,这种速度也越来越难以维持。因此,对于HBM4计划进行更实质性的改变,把内存堆栈接口从1024位扩展至2048位,这将是自八年前推出这种内存类型以来HBM规范最重要的变化之一。

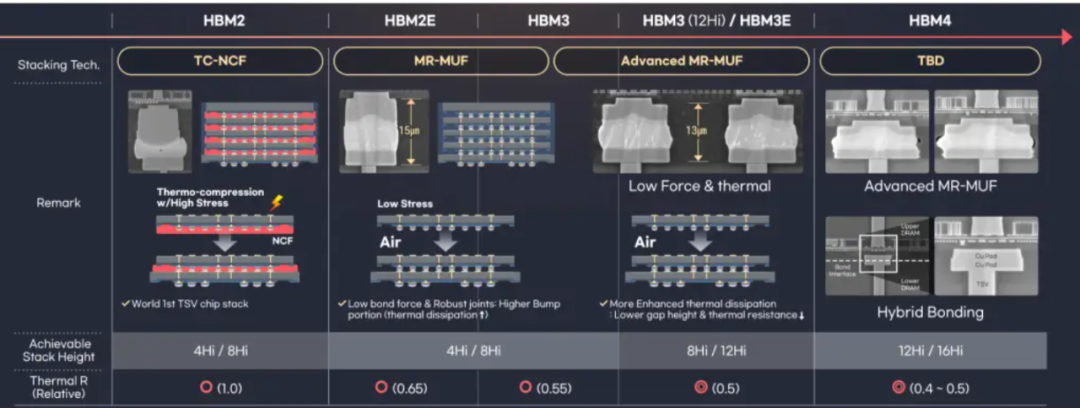

现有的HBM采用了TC(热压)键合技术,该技术在DRAM中创建TSV通道,并通过小突起形式的微凸块进行电连接。使用现有的接合实际上不可能在720μm处实现16层DRAM堆叠HBM4,业界关注的替代方案是混合键合(Hybrid bonding)。

混合键合是一种在芯片和晶圆之间直接键合铜布线的技术,相较于传统的键合工艺,摒弃了在DRAM内存层间添加凸块的繁琐步骤,这不仅提高了信号传输速率,同时也降低了DRAM层间距,使得HBM模块的整体高度得到缩减。

HBM4在堆栈的层数上也有所变化,除了首批的12层垂直堆叠,还会带来16层垂直堆叠。此外,HBM还会往更为定制化的方向发展,不仅排列在SoC主芯片旁边,部分还会转向堆栈在SoC主芯片之上。

sk海力士

根据SK海力士最新公布的信息显示,HBM4将比第五代HBM3E速度提升40%,而耗电量仅为后者的70%,并在5月举行的记者招待会上表示,其HBM4内存的量产时间已提前到2025年。具体来说,计划2025年下半年推出采用12层DRAM堆叠的首批HBM4产品,而16层堆叠HBM稍晚于2026年推出。

同时,SK海力士将继续采用批量回流模制底部填充(MR-MUF:Mass Reflow-Molded Underfill)先进封装工艺作为核心技术。其中,批量回流焊(MR)是通过融化堆叠芯片之间的凸块,让芯片互相连接;模塑底部填充(MUF)是在堆叠的芯片之间填充保护材料从而提高耐久性和散热效果。

但是MR-MUF有容易翘曲、导致晶圆末端弯曲、空洞现象(即保护材料在某些区域分布不均匀)等缺点。SK海力士表示,与HBM开发初期相比已经成功地减少了翘曲现象,目前正在开发克服这一问题的技术。作为替代方案而出现的混合键合技术则预计由于HBM标准的放宽而缓慢引入。

SK海力士还计划在HBM4基础裸片上采用台积电的N5和N12FFC+工艺,以便可以将附加功能封装到有限的空间中,也有助于其生产定制HBM。SK海力士和台积电还同意合作优化SK海力士的HBM和台积电的CoWoS(基板上晶圆芯片)技术的集成,响应常见客户与HBM相关的要求。

三星

和SK海力士不一样,三星采用的TC-NCF(thermal compression with non-conductive film),也就是非导电薄膜热压缩技术封装HBM。该技术在每次堆叠芯片时,都会在各层之间放置一层不导电的粘合膜,用于使芯片彼此绝缘并保护连接点免受撞击。这种方法的优点是可以最大限度地减少随着层数增加和芯片厚度减小而可能发生的翘曲,使其更适合构建更高的堆栈。

优化热量和压力是TC-NCF成功的关键。在三星看来,HBM的热阻主要受芯片间距的影响,减少芯片之间NCF材料的厚度,并利用热压缩技术使芯片更加紧密,实现了业界最小的7μm芯片间距。此外,在芯片键合过程中,三星策略性地设计了需要信号传输的小凸块和散热至关重要的大凸块,优化增强了散热和产量。

SK海力士在第二代HBM之前也使用NCF ,但从第三代(HBM2E)开始改用MUF(特别是MR-MUF),分析人士更是认为MUF是SK海力士能够在HBM市场脱颖而出的原因。不过,三星副总裁Kim Dae-woo表示,在最多8个堆叠时,MR-MUF 的生产效率比TC-NCF更高,但一旦堆叠达到12个或以上,后者将具有更多优势。

据三星的规划,HBM4将在2025年生产样品,希望通过针对高温环境优化的NCF组装技术以及混合键合技术等尖端工艺技术,利用逻辑代工+HBM内存+先进封装的全流程方案与SK海力士争夺HBM订单。此外,三星还公布了其HBM技术蓝图,预测到2026年,其HBM的出货量将比2023年高出13.8倍。

美光

美光科技也加快了追赶两家韩国存储巨头的步伐,披露了暂名为HBMnext的下一代HBM内存,业界猜测这有可能便是其HBM4,预计将提供36GB和64GB容量,这意味着多种配置,例如12-Hi 24Gb堆栈(36GB)或16-Hi 32Gb堆栈(64GB)。至于性能,美光宣称每个堆栈的带宽为1.5TB/s~2+TB/s,这意味着数据传输速率超过11.5GT/s/pin。不过在技术细节上,美光并未公布太多信息。

三星和SK海力士不同,美光并不打算把HBM和逻辑芯片整合到一个芯片中,似乎想要通过HBM-GPU的组合芯片形式以获得更快的内存访问速度。不过随着机器学习训练模型的增大和训练时间的延长,通过加快内存访问速度和提高每个GPU内存容量来缩短运行时间的压力也将随之增加,而为了获得锁定HBM-GPU组合芯片设计(尽管具有更好的速度和容量)而放弃标准化DRAM的竞争供应优势,可能不是正确的前进方式。

全球HBM销售额预计将从2023年的16亿美元,增长到2027年266亿美元,年均增长率为59%。据路透社报道,HBM目前占通用内存市场的15%,而去年这一比例为8%。SK海力士在HBM市场拥有最大的市场份额,是占据AI GPU市场80%份额的英伟达的HBM3内存唯一供应商,并于今年三月开始量产最新一代HBM3E。

美光和三星等竞争供应商正在开发HBM产品,以阻止SK海力士主导市场。据媒体最近报道,三星已通过或即将通过英伟达HBM3E认证,并有望在下季度或第四季度开始向英伟达供货,尽管三星取得了一定进展,但短期内其HBM销售额可能不会显著增加,SK海力士凭借其市场主导地位和高利润率,仍将在未来几年内保持强劲增长。

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码

相关文章

-

2024-08-06

-

-

-

-

网络与存储 2024-08-05

-

-

-