AMD Instinct加速器系列亮相Computex 2024

AMD董事长兼首席执行官丽莎Su博士在Computex主题演讲中公布了AMD Instinct加速器系列的重大进展。该公司宣布了加速器的扩展多年路线图,承诺每年改进AI性能和内存功能。这标志着人工智能和数据中心工作负载的创新新时代。

AMD Instinct MI325X加速器

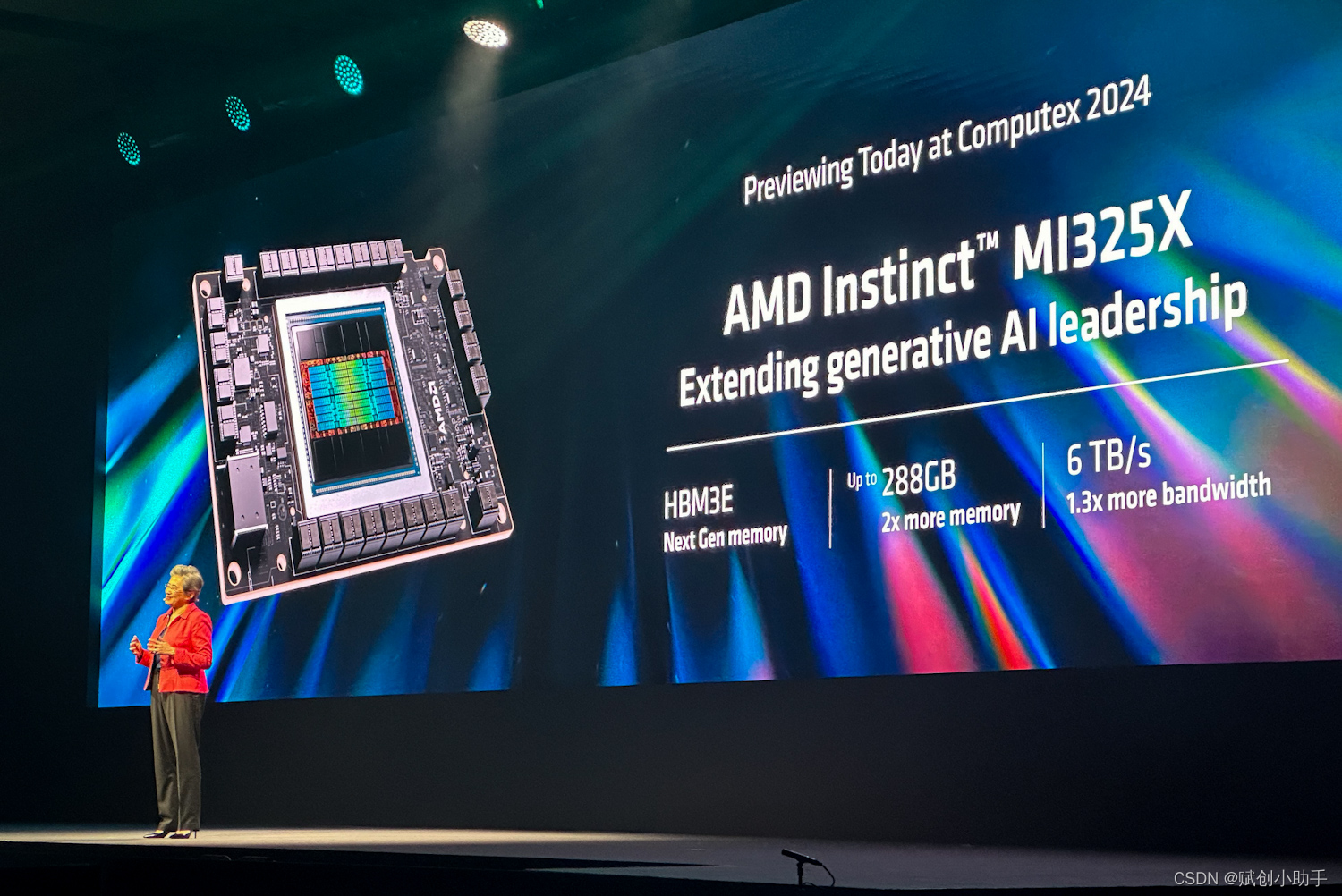

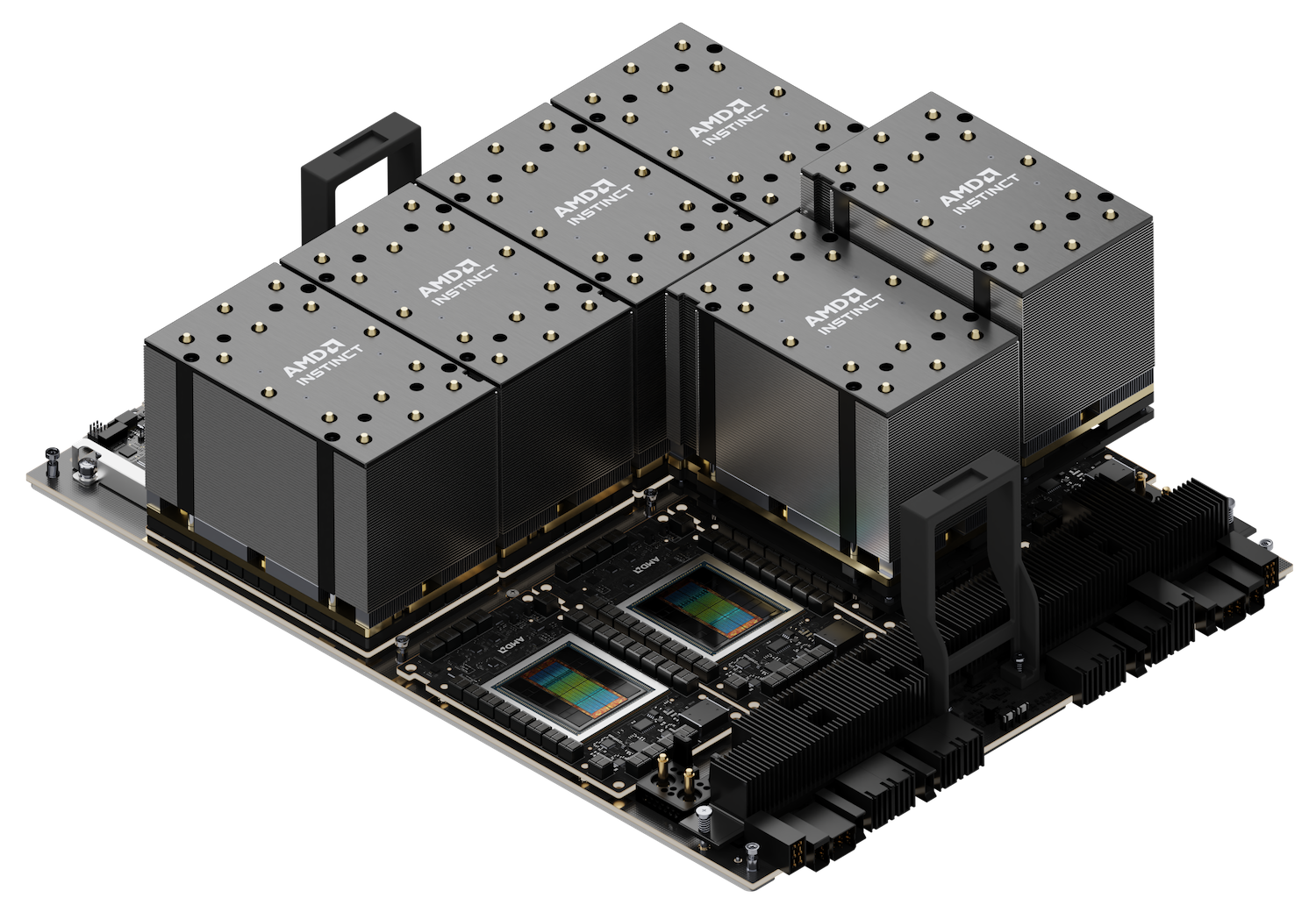

更新的路线图以新的AMD Instinct MI325X加速器开始,该加速器将于2024年第四季度上市。该加速器具有288GB的HBM3E内存和每秒6 TB的内存带宽。它采用通用基板服务器设计,确保与AMD Instinct MI300系列兼容。

MI325X拥有业界领先的内存容量和带宽,性能分别是竞争对手的2倍和1.3倍。它提供了比竞争对手高1.3倍的计算性能,使其成为AI工作负载的强大工具。

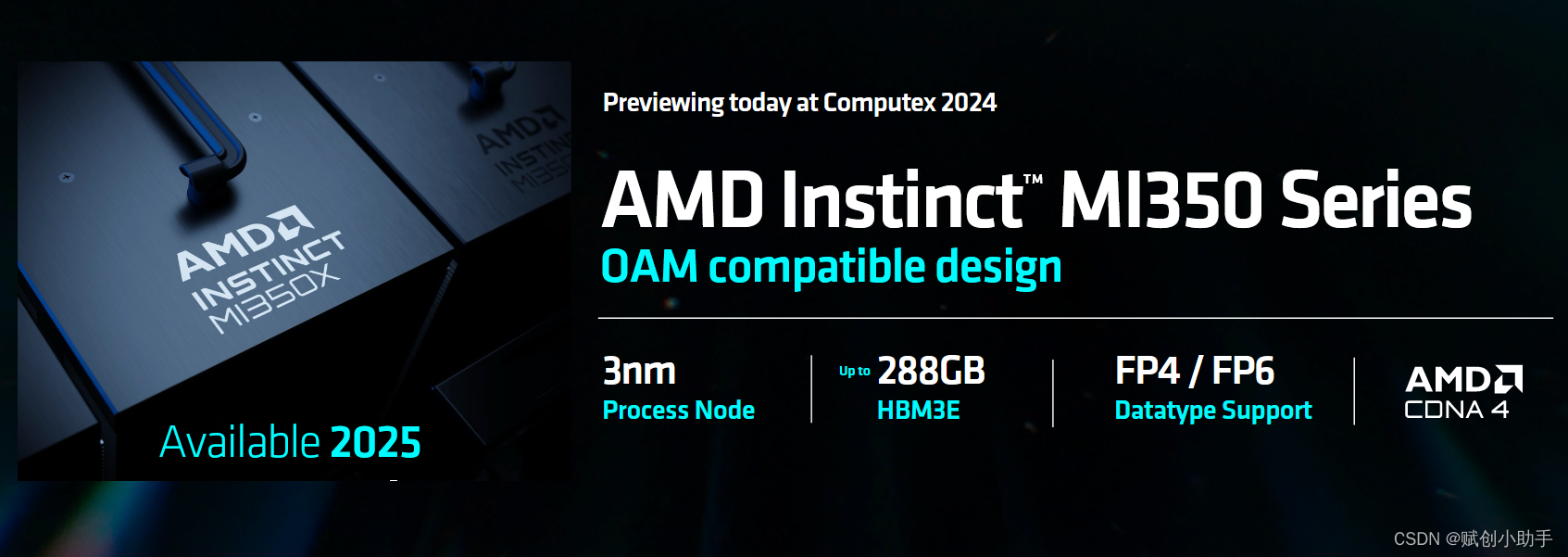

下一代:MI350和MI400系列

继MI325X之后,AMD Instinct MI350系列将采用全新的AMD CDNA 4架构,预计将于2025年推出。该系列将在AI推理性能方面带来实质性飞跃,预计与AMD Instinct MI300系列相比将增加35倍。MI350X加速器将保持通用基板设计,采用先进的3nm工艺技术,支持FP4和FP6 AI数据存储器,并具有高达288GB的HBM3E内存。

由AMD CDNA“Next”架构驱动的AMD Instinct MI400系列将于2026年发布。

AMD Instinct MI300X加速器的采用和影响

AMD Instinct MI 300 X加速器已被主要合作伙伴和客户广泛采用,包括Microsoft Azure、Meta、Dell Technologies、HPE、Lenovo等。AMD数据中心加速计算公司副总裁布拉德·麦克雷迪(Brad McCredie)强调了MI 300 X加速器的卓越性能和价值主张,并指出了它们在推动人工智能创新方面的重要作用。他说:“随着我们每年更新产品的节奏,我们坚持不懈地推进创新步伐,为人工智能行业提供领导能力和性能,我们的客户希望推动数据中心人工智能培训和推理的下一次发展。

AMD AI软件生态系统的进步

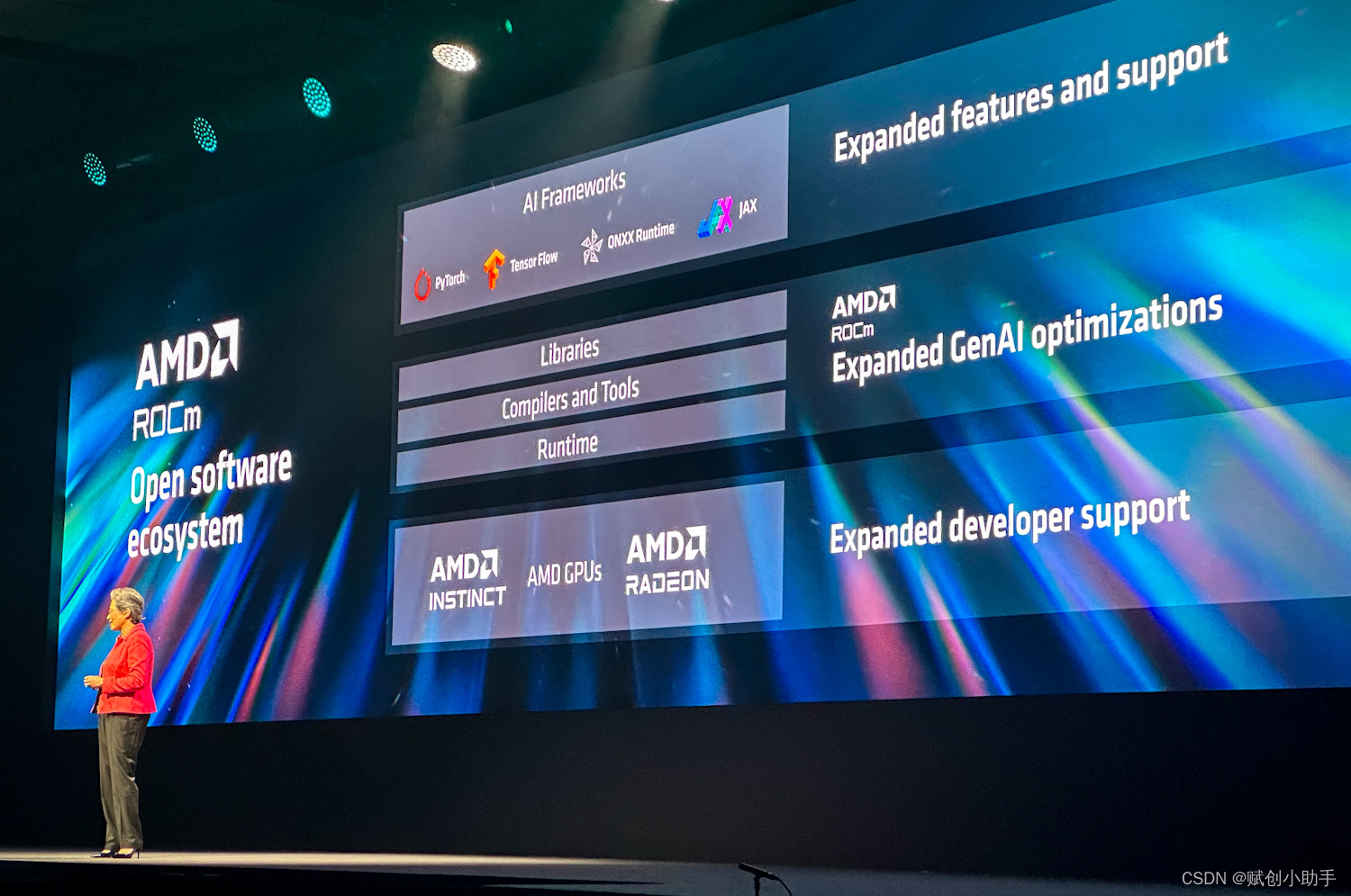

AMD ROCm 6开放软件堆栈不断成熟,使AMD Instinct MI 300 X加速器能够为流行的大型语言模型(LLM)提供令人印象深刻的性能。在使用八个AMD Instinct MI 300 X加速器和运行Meta Llama-3 70 B的ROCm 6的服务器上,客户可以实现比竞争对手高1.3倍的推理性能和令牌生成。

此外,在Mistral-7 B上,一台配备ROCm 6的AMD Instinct MI 300 X加速器在推理性能和令牌生成吞吐量方面的表现可超过竞争对手1.2倍。

AMD与最大的AI模型库Hugging Face的合作进一步强调了生态系统的稳健性。Hugging Face每晚测试700,000个最受欢迎的型号,以确保在AMD Instinct MI300X加速器上实现无缝功能。AMD还在继续其与流行的AI框架(如PyTorch、TensorFlow和JAX)的上游工作,以确保广泛的兼容性和增强的性能。

关键路线图亮点

在主题演讲中,AMD公布了AMD Instinct加速器路线图的最新年度节奏,以满足对人工智能计算不断增长的需求。这确保了AMD Instinct加速器将继续推动下一代前沿AI模型的开发。

- AMD Instinct MI325X加速器:将于2024年第四季度推出,该加速器将配备288GB HBM3E内存,每秒6 TB的内存带宽,以及行业领先的内存容量和带宽。与竞争对手相比,它的计算性能提高了1.3倍。

- AMD Instinct MI350系列:预计在2025年,MI350X加速器将基于AMD CDNA 4架构,并使用先进的3nm工艺技术。它将支持FP4和FP6 AI数据库,并包括高达288GB的HBM3E内存。

- AMD Instinct MI400系列:计划于2026年推出,该系列将利用AMD CDNA“Next”架构,引入新特性和功能,以增强AI训练和推理性能。

广泛的行业采用

对AMD Instinct MI300X加速器的需求持续增长,众多合作伙伴和客户利用这些加速器来处理要求苛刻的人工智能工作负载。

AMD在Computex 2024上推出了扩展的Instinct加速器路线图,标志着该公司在人工智能和数据中心战略的重要里程碑,展示了其技术创新和市场竞争力,同时也为未来的产品发展和生态系统建设奠定了基础。

关键词: AMD 加速器 Computex 2024

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码

相关文章

-

2024-08-06

-

-

2024-07-23

-

-

-

-

-