Arm Neoverse 新动态助推基础设施AI应用表现

随着人工智能 (AI) 渗透到教育、就业、制造、医疗和交通等领域,AI 正在改变经济发展和Arm的日常生活,Arm 构建了全球应用最为普及的 CPU 架构,在多个领域的技术革新中发挥主导作用,影响了世界各地人们的日常生活。AI技术的光明前景让算力资源开始逐渐向AI应用需求倾斜,甚至在最近一两年新配置的算力基础设施中如果没有更好的AI应用支持,可能会很快被市场所淘汰。Arm 高级副总裁兼基础设施事业部总经理 Mohamed Awad直言,Arm 是这一切变革的基石。

众多国际知名的大型科技企业正基于 Arm 平台构建新一代系统和基础设施。谈到Arm 为何能在基础设施领域收获累累硕果?Mohamed Awad总结了三大原因:首先是卓越性能,Arm的工程团队坚持不懈地实现迭代提升;其次是灵活性,Arm赋能技术合作伙伴定制芯片,以支持其专用的工作负载和系统,而非采用一体适用的方案;最后是生态系统,Arm在软件、 IP 和芯片生态系统中提供出色性能和灵活性,从而降低配置的总成本并加速产品上市。Arm独特的定位,皆因结合这些优势,帮助合作伙伴随时随地以任何方式进行部署。Arm Neoverse 计算子系统 (CSS) 将这些优势演绎得淋漓尽致。而Arm 全面设计 (Arm Total Design) 生态项目便是以此为基础,提供了一个生态系统,参与其中的合作伙伴均致力于无缝交付基于 CSS 的定制芯片。

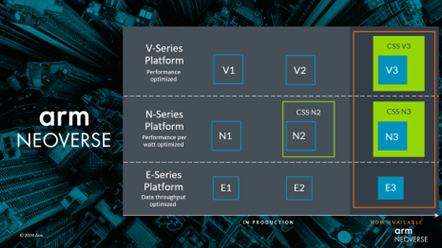

针对这样的市场需求,Arm近期推出的两款全新 Neoverse CSS 产品均基于全新的第三代 Neoverse IP 构建,通过全新的平台和计算子系统,Arm扩展了 N 系列的CSS产品路线图,推出Neoverse CSS N3,使每瓦性能更上一层楼。与此同时,Arm也针对性能优先的 V 系列平台推出新一代产品,并首次将计算子系统引入该产品线,推出Neoverse CSS V3。凭借新的 CSS N3 和 CSS V3,Arm专注于释放芯粒(Chiplet)等新技术的潜力,并更大限度地优化实际工作负载的总体拥有成本 (TCO),这对于整个生态系统至关重要,其中包括 AI、数据库、网络等。

谈到新推出的Neoverse CSS N3,Arm 基础设施事业部产品解决方案副总裁 Dermot O’Driscoll突出强调的就是能效。CSS N3 与 CSS N2 相比,其每核心的每瓦性能提升 20%。Arm对 CSS N3 进行了调优,以填补Arm发现的市场空缺,提供满足基础设施性能要求的高效计算。

CSS N3 的首个实例可提供 32 核,热设计功耗 (TDP) 低至 40W。其可扩展性非常强,可覆盖电信、网络和 DPU 等一系列应用。Arm也同时考虑横向扩展云配置。CSS N3 基于新的 Neoverse N3 IP 平台打造,为新的 N 系列产品引入了 Armv9.2 功能,能为每个核心提供 2MB 的专用 L2 缓存,并支持最新的 PCIe 和 CXL I/O 标准以及 UCIe 芯粒标准。

有些客户希望在保有 CSS 所有优势的同时,实现更高的性能。因此,Arm还将 CSS 项目扩展到V 系列核心,推出了 Neoverse CSS V3。与 CSS N2 产品相比,CSS V3 的单芯片性能提高了 50%。CSS V3 在单芯片上最多可扩展至 128 核,并支持最新的高速内存和 I/O 标准。CSS V3 基于Arm新的 Neoverse V3 核心打造,是 Arm 目前单线程性能最高的 Neoverse 核心。V3 为 Arm 机密计算架构 (CCA) 提供硬件支持。V3 和 N3 核心均可提供业界领先的专用 L2 缓存大小,显著改善性能表现。

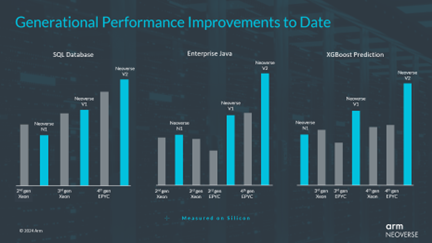

谈到新 CPU 核心的性能提升,Dermot O’Driscoll展示了新产品全方位的表现提升,从视频处理到 SQL 数据库的性能均有所跃进。如今,人们常常忽视的一点是,有多少计算周期最终被用于压缩和协议转换等后台任务。N 系列在压缩方面取得了性能优势,可降低云服务运营商的成本,并最终降低云服务客户的成本。同样地,V 系列显著提高了协议缓冲区的性能,这是在数据中心内传输数据的一项关键功能。

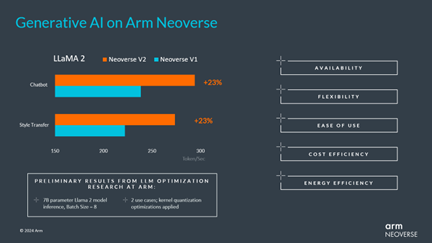

AI是基础设施不可避免的话题,Dermot O’Driscoll认为,2023年有关 AI 的讨论焦点主要集中在生成式 AI 和大语言模型 (LLM) 上。目前行业重点更多放在训练 LLM 上,但随着生成式 AI 广泛应用于实际业务场景,其工作重点将转向推理。有些分析师估计,已部署的 AI 服务器中有高达 80% 专用于推理,且这一数字还将持续攀升。这一转变意味着要找到合适的模型和模型配置,并加以训练,然后将其部署到更具成本效益的计算基础设施上。吞吐量是其中一部分考虑因素,而在当今广泛部署的基于 Arm 架构的芯片上,Token 生成吞吐量表现相当优异。但还有许多其他因素需要纳入考量。CPU 广泛可用,并可灵活用于 ML 或其他工作负载,此外,CPU 还易于部署,并可支持各种软件框架,具备低成本和高能效等优势。因此,CPU 推理将是生成式 AI 计算应用的关键组成。Arm可以看到,这些工作负载已从 ML 专用的 Neoverse 功能(如 Bfloat16、MatMul、SVE 和 SVE2),以及Arm的微架构优化中受益,而且这一趋势还将继续。

但显然,并非所有 AI 处理都将在 CPU 上进行。打造 AI 加速器的公司非常多。据最近统计,这一领域的公司已接近 80 家。每家公司都想取得 NVIDIA 那样的成绩,而 NVIDIA 不仅利用其领先的 Hopper GPU,同时也使用了基于 Neoverse V2 平台的紧耦合计算芯粒 Grace。NVIDIA Grace Hopper 的一大关键创新在于内存容量和共享内存模式。这种紧耦合的 CPU 加上加速器配置,对大参数 LLM 非常有益,对检索-增强-生成 (RAG) 等新兴方法也很有帮助。Neoverse CSS 是专为帮助客户在基于Arm领先的 CPU 平台上,快速打造通用计算芯粒而推出的产品。它能提供客户所需的所有接口,以便选择耦合自身的加速器。这种方法既可以在需要 CPU 时提供 CPU,又可以在需要 AI 加速器时提供 AI 加速器,做到两全其美。

越来越多的 AI 工作负载被采用,并贯穿于整个计算流程,涵盖从大型数据中心到网络、服务器以及计算基础设施的方方面面。Arm 此次推出的Neoverse V3 和 N3 可以提供支撑这一转型所需的计算性能和效率,而在 Arm 全面设计生态项目的支持下,Arm的计算子系统能够加速产品上市时间,并加大对创新的投资力度。Neoverse 只是 Arm 为各个行业市场提供经 AI 优化的计算平台的一个例子。Arm 的独特之处在于其背靠庞大的生态系统,始终坚定不移地推动技术创新,为合作伙伴赋予了灵活的创新空间,为未来计算及 AI 起到基石作用。

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码

相关文章

-

2024-08-06

-

-

-

-

-

-

-