从“AI向好”到“AI向善”,呼唤以人为本的AI

2023年10月28日,在沈阳举办的CNCC2023(2023年中国计算机大会)上,美国斯坦福大学终身名誉教授James Landay做了特邀报告。他认为AI系统对人类社会带来巨大的影响,但仅仅认识到这些影响还不够,要真正地以人为本。为此,AI 的开发必须要考虑三个层次:以用户为中心,以社区为中心,以社会为中心。“以用户为中心”是考虑最终用户的需求和能力,“以社区为中心”使社区参与到设计的早期,“以社会为中心”预测并调节其在社会层面的潜在影响。成功的以人为本的AI 需要除专业技术人员以外的多学科团队的早期参与,包括设计、社会科学/ 人文学科、医学和/或法律等相关领域的专家及社区成员。

1 AI的正面和负面影响

AI(人工智能)是强大的工具。如果你设计AI系统,你会希望构建能产生积极社会影响的AI。

当前AI正在许多领域席卷世界,从使用AlphaFold等工具进行科学发现,到我们所有人每天用来翻译业务文档或与世界各地同事交流的自然语言处理,甚至影响到时尚界——时装公司正在使用AI 来确定下一季的款式,以及如何优化供应链,以节省材料。

在过去的一年里,生成式AI的出现更引发了风暴。ChatGPT为你的问题提供答案,Midjourney可以绘画,Copilot帮助你轻松编程。

尽管我们每天都能看到AI 的身影,但AI不一定全是好事,AI操纵着当今的社会智能,在操纵社交网络——人们为之悲喜,或更糟糕的是,AI引发的事件甚至终结了民主。例如在美国,有AI对犯罪进行有偏见判决的报道,《纽约时报》2017 年5 月报道称,有人《被软件程序的秘密算法送进监狱》。ProPublica(注:总部设在纽约市曼哈顿区的非盈利性公司,主要为公众利益进行调查报道)于2016 年5 月报道称,全国各地都在使用软件来预测未来的罪犯,这在某种程度上会出现有偏见的判决(笔者注:例如模型如果有偏见或错误,会导致结果偏差)。

2 AI应关注其对人类和社会的影响

根据AI 会导致积极和消极的原因,大约五年前,Landay 团队在斯坦福大学“ 以人为本的AI 研究所(HAI)”提出了发展AI 的三个原则。

首先,AI 应该关注其对人类社会的影响。其次,AI 应该受到人类智慧的启发。人类大脑仍然是宇宙中重要的智慧之源。

第三,AI 应该增强而不是取代人类的能力。无可置疑,AI 将重塑全球劳动力的组成结构,因此,政府及相关机构应该为这场剧变做好准备。

关于第三点,需要强调的是,AI 可以增强人类的能力,因此可以采用特定的设计来创造和利用AI,帮助人们更好地完成任务,而不是简单地考虑替代。

现在,有许多负面的社会影响。例如一些专家在有影响力的领域使用AI,但AI 会失败。《麻省理工学院技术评论》2021 年7 月30 日曾报道,《已经制造了数百个AI 工具来捕捉新冠病毒,但它们都没帮上忙》。《Quartz》发布了标题为《AI 还有很长的路要走,医生才能相信》的文章,称有时专家在一些有影响力的领域(例如放射科)使用AI,但可能会错误地解决了问题。

因此,认识到AI 的正面影响并不足够。在促进AI的良性发展中,还要考虑更多方面。经常看到这种类型:专家试图在某一领域使用AI,但有时会失败。因为这项技术并不是单一存在的,这种情况一再发生。例如就像刚才《麻省理工学院技术评论》文章中所看到的那样,人们已经建立了数百个AI 工具,但没有一个有真正的帮助。在放射科也是如此,斯坦福放射科医生和AI 研究员Curt Langlotz 认为:AI 会取代放射科医生吗?这是一个错误的问题。正确的答案是:使用AI 的放射科医生将取代不使用AI 的放射科医生。究其原因,这通常是由于研究人员用来测算的理想数据集与现实世界有所差异。目前最大的挑战是:我们不知道如何设计AI 系统来增强人们的能力,并产生积极的社会影响。

3 如何设计AI系统来增强人们的能力

相信还有更好的方法,即:以人为本的AI。我们如何对AI 进行积极控制,以避免其带来的负面影响?

为此,我们需要设计和分析这三个层次的系统:用户、社区和社会。这样做才能创造积极的技术。

● 以用户为中心。我们首先需要有一个以用户为中心的流程,需要整合自己的设计和人机交互的技术,以满足用户的需求。

● 以社区为中心。但仅仅拥有以用户为中心的设计流程是不够的。正如上述危害性的案例所述,为法官创建了一个很好的AI系统,但它只理解数据,忽视了社区影响:原告和被告的家人、律师等。我们需要了解他们来自不同社区的问题,以及他们面临的结构性障碍。所以在量刑之前,我们不仅要访问和观察相关的人,也可以使用AI 系统。可见,以用户为中心和以社区为中心之间存在着互动。但即使这样还不够。

● 以社会为中心。如果我们建立的这个系统变得更加普遍,就像美国许多州和地方使用的指导系统一样,将会发生什么?在美国的监狱系统中,有很大的比例是非洲裔美国人,如何防范种族歧视。我们需要建立一个预测系统,当建立的系统影响力巨大时,可能会发生什么,并从一开始就尝试设计调解社会影响。

预测上述影响并不容易。这就是为什么要拥有一支跨学科的团队,而不仅仅是计算机科学家,这一点尤为重要。我们需要来自医学、法律、社会科学/ 人文科学或环境科学等领域的专家决定我们将要建立的系统。这些专家必须从一开始就是AI 项目的合作伙伴,而不是在项目接近尾声时添加进来,以预测可能的危害。

Landay将举两个例子来说明以用户、区域、社会为中心的AI系统。第一个主要来自大众媒体的资讯,对自动驾驶汽车的探讨。第二个是Landay 自己研究项目团队,展示他们过去所做的项目的分析方法,该项目是如何让建筑减轻人们的压力。

4 案例1:自动驾驶汽车对人类行为的影响

特斯拉等汽车公司都有自动驾驶的愿景。这个愿景是否像我们所相信的那样?一二十年后,也许这些汽车公司会让你相信这一点。但Landay 想说的是,在过去三四十年里,大多数高校和行业研究人员就在做这件事。当Landay 还是卡内基梅隆大学的一名大四学生时,有一天,看到一辆卡车使用自动驾驶技术缓慢驶过匹兹堡校园旁的雪莉公园。

● 以用户为中心。目前的自动驾驶汽车的研发主要是以用户为中心的。

● 以社区为中心。需要关心其他交通道路参与者无论是对于其他自动驾驶汽车还是非自动驾驶汽车,以及与行人、骑车人的互动。例如《财富》曾报道,《汽车保险监管机构警告称,自动驾驶汽车可能在夜间无法发现行人》。

● 以社会为中心。我们需要考虑自动驾驶汽车对城市或地区的影响。也许影响并没有那么积极。例如,《记者》2019 年5 月21 日的署名文章《自动驾驶汽车:天堂还是地狱?》认为,自动驾驶汽车带来了更大的交通流量、伤亡和浪费,因为开车行驶的里程越来越远,人们住在更远的地方,车里也空空荡荡的。

Landay联想到自己采用自动驾驶汽车的未来场景:他住在斯坦福大学——在旧金山以南约40 英里处。他下周在旧金山有个会议。他打算开车去,但不想花75美元停车,如果他有一辆自动驾驶汽车,可能会让它自己开回家,或者让它停到旧金山南部更便宜的停车场。

或者尽管他在斯坦福大学工作,但附近房价高,也许他会搬到两个小时车程以外的加州中部山谷,那里的费用要低得多,每天早上他将花两个小时在路上,他可以睡在自动驾驶汽车里,或者在路上准备教学的课件。

可见,自动驾驶汽车会导致人们行为的变化。

《每日得克萨斯人》2022 年8 月20 日文章称,《得州大学研究人员发现自动驾驶汽车功能如何抵消道路安全》,称至少在得克萨斯州,从休斯顿、达拉斯、圣安东尼奥到奥斯汀的三角形区域中,自动驾驶汽车会因人类行为的变化而导致交通堵塞。因为旅行者正在向更远的地方迁移,人均出行距离从14 英里上升到16 英里。随着旅客转向自动驾驶/ 地面交通,该地区内航空公司的客运量将下降82%。

这里并不是在探讨自动驾驶汽车对或不对。而是认为如果按照这种以“用户、社区、社会”为中心的方法分析,从一开始,我们就尝试这样的考虑:也许自动驾驶汽车或自动驾驶公交车仍然是正确的解决方案,但我们也可以考虑如何建设一个更好的公共交通系统。

不仅在美国,当我们来到北京、巴黎、伦敦……返回家中,火车、公共汽车和地铁等公共交通系统给我们留下了深刻的印象。

如果我们一开始只针对以用户为中心的设计和分析,您可能会在一开始就忽略公共交通系统。这涉及权力问题,谁有权选择?我们如何利用社会资源?现在这种权力非常集中,尤其集中在AI 和少数有能力制定大模型语言或行业规则的大公司中。

5 案例2:2030年的工作场所

多年来,Landay团队在做的一个项目是如何帮助建筑物中的人们保持健康。

尽管自动化和数字化不断发达,但许多美国人仍感到压力很大,没有灵感,久坐不动,被边缘化。而越来越多的人意识到建筑会影响健康,因为人们大部分时间是呆在建筑物中。据美国环保局的数据,美国人87%的时间在家或办公室等室内建筑里。因此,研究在建筑物中的减压方式很有必要。

Landay团队研究了建筑物的特征对人的压力的影响,如材料、光、声音等,并思考如何重新设计空间,使其能感知人们的状态,并进行动态调整,以安慰身处其中的人。

1)未来的建筑会和人互动

Landay展示了5年前拍摄的视频片段。未来的办公室可以察觉到工作者的压力,并调整空间的环境,例如调整灯光或音乐。

在公共空间,可看到墙上有一个动态的镜子(笔者注:认为是显示屏),指引我沿着显示的方向回家。因为屏幕上的花在风中飘扬,所以我可能很好奇,想看看那里发生了什么。现在我走向了楼梯,而不是电梯的方向,这鼓励我多锻炼(如图1)。

图1

2)研究材料、光、声对人的影响

以往的研究常是小规模、短期、基于自测的,研究者可能会让实验者在他们的旧建筑里填写一份调查,然后在他们搬进新建筑一个月后再次填写调查。

Landay团队采取了更加综合的科学步骤。首先建立了建筑属性如何影响人的理论,然后进行动态适应的设计,最后需要了解人们保护隐私的程度,以及他们愿意向建筑透露什么,以获得帮助和益处。

Landay团队花费了1年时间,请了400人参与实验,系统地研究了不同的建筑特征。例如桌椅的材质是人造板材还是天然木材,还考察了自然光、人造光(无窗场景)的影响,色彩是单一的(白色)还是多色等(图2)。

图2

在测试减压方面,通过摄像头,或者受试者戴着手环和苹果手表来检测压力。用各种方法测试进行实验,其中一种方法是在两分钟内通知参与者要做一个演讲,实验者将记录参与者的积极和消极情绪。

测试的结论是:天然材料有助于最大程度地减少参与者的压力。

如图3,可以看到左图的绿色柱条(注:代表天然材料)降低了压力。右图可见绿色会下降到更低的水平,并更快地恢复。

图3

对于自然光和人造光,Landay团队也得到了类似的结果。这个研究报告详细地刊登在《建筑与环境》期刊2022年224卷,作者是Douglas 等人(如图2)。

如果要进行更大规模的研究,可能会在一个真正的办公室里用更复杂的方式来测试。

3)产生压力的因素

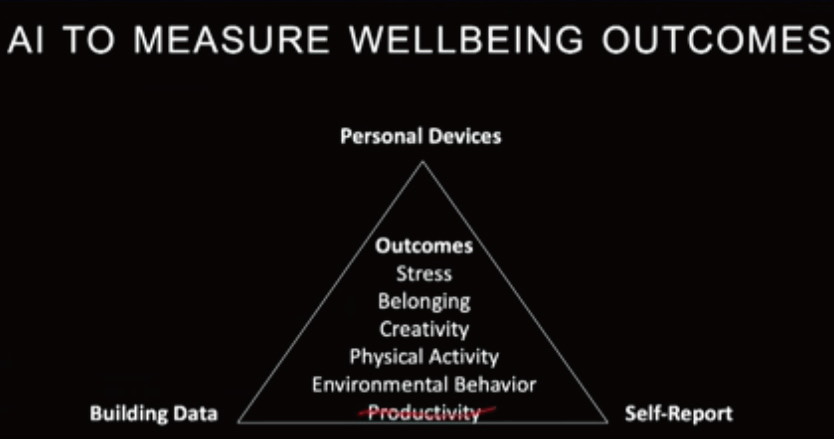

在测试压力方面,考察了收入、财产、创造力、体育活动和环境行为因素(图4)。这里忽略了生产力因素,因为这方面其他的研究已很多。你可以想想亚马逊购物网仓库的工人,如果他们包装得不够快,就会被解雇。

图4

研究需要从真实的办公室获得信息,而不打扰他们的工作。因此,可以利用从环境获得的建筑数据,例如多少人进出房间、能源的消耗等。同样,也可以使用自测报告,可能向实验者的手表、手机上一天多次发送问卷,询问压力有多大。第三种方法,也可以使用实验者的手机、手表等个人设备的数据,但这种类型的数据包含很多个人信息,所以也需要考虑隐私问题。Landay团队用这些数据来衡量人的压力级别。所有的研究都是经常进行的。并需要确保数据是安全的,只有合适的人才能看到。

4)沟通与隐私保护的结合

智能空间的一个很大问题是如何与个人用户沟通,我们信任和使用哪些数据? Landay 团队工作的很大一部分涉及人所拥有的物理数字空间。现在,产品沟通问题的一种方式是使用隐私政策,但这些政策毫无用处。例如,有许多常见的产品的隐私政策,但有多少人阅读了这些隐私条款?很少有人这么做。因为这些内容并不是为了向你传达正在发生的事情,纯粹是走法律流程。

以上是以用户为中心的隐私考虑。

我们如何沟通智能空间中正在发生的事情?

图5是一位艺术家所创作的形状像人眼(注:会转动)的网络摄像头(Eyecam),它在观察你及周围的环境。这是一种越来越常见的沟通方式。例如,也许你的手机或笔记本电脑上有一个小绿灯,可以将你的录音发到云端审查。

图5

Alias是一种可教育的“寄生虫”(如图6)。你可以把它放在你的智能扬声器/ 语音助手上。只有当你给出你定义的关键词时,它才会解锁,使得谷歌、亚马逊、苹果或百度等语音助手无法监听你的谈话,以保护你的隐私。

所以在与AI沟通时,我们希望把沟通和保护隐私这两种方式结合起来。

图6

该如何做到呢?我们的隐私有可能泄露,这让我们感到不安。关于社区和社会层面,Landay举办了几场研讨会,探讨了隐私风险、价值权衡和潜在的创新干预。

Landay团队进行了大量测试,参与者多种多样,有不同的生活经历。在含义设计阶段,人们试图为如何保护这些隐私威胁建立原型。在行动回合中,人们进行团队合作,一个团队构成威胁,另一个团队来对抗威胁。这必须通过多次迭代来学习,使其更像是一个合作的游戏,而不是一个竞争的游戏,才能获得好的结果。

最近的实验是在2023年9月,这个项目用于旧金山一个有13名老年人参加的研讨会,以探索基于语音的AI技术如何影响他们。在考虑价值观背景、残障程度和种族之前,他们被分为三组。首先给他们一些设备之后,询问他们的家庭、健康状况,并与他们的医生沟通。主医生可以在屏幕上看到一些内容,护士也有类似的访问能力。受试者可以与家人和朋友进行不同程度的互动。如果有问题,受试者可以按下蓝色按钮(例如感到恐慌),它会调节你的呼吸,使你放松、平静。红色按钮:停止一切。黄色:恢复。

以上部分研究了用户和社区层面。

在社会层面,Landay团队将会考察谁将有进入这些建筑的特权:有隐形残疾或边缘化身份的人,他们不想透露;任何进入建筑物的人(例如送货员、访客)或在外面工作的食品摊贩;建筑住户、管理人员等。这次研讨会确实让Landay 团队能够进入更高层次的分析。

6 结束语

AI的许多伟大应用帮助人们更好地完成任务,帮你成为更好的学习者、更好的设计师或更好地照顾身体。关键是将用户、社区和社会的需求置于智能界面设计的中心。在这三个层次上进行设计是至关重要的。

我们现在还处于这方面的早期阶段,已找到了正确的设计流程。如果在你的工作中,只需把你的以用户为中心或社区为中心提升一个级别,在对人们产生积极影响的方面,你的AI 系统将会做得更好。

讲者介绍:James Landay是斯坦福大学工程学院的计算机科学教授。他是斯坦福大学以人为本的AI研究所(HAI)的联合创始人和副所长。他之前是康奈尔理工大学、华盛顿大学和加州大学伯克利分校的终身教职员工。他还是西雅图英特尔实验室主任和NetRaker的联合创始人。在北京微软亚洲研究院休假期间,他在清华大学教了一个学期的书。Landay在加州大学伯克利分校获得了EECS(电气工程与计算机科学)学士学位,在卡内基梅隆大学获得了计算机科学硕士和博士学位。他是ACM(美国计算机协会)SIGCHI(计算机-人交互的特殊兴趣小组)的成员和ACM研究员。他在美国国家科学基金会CISE咨询委员会任职六年。

(本文来源于《EEPW》2024.3)

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码