揭秘FPGA:为什么比 GPU 的延迟低这么多?

▲Open Compute Server 在机架中。

▲Open Compute Server 内景。红框是放 FPGA 的位置。

▲插入 FPGA 后的 Open Compute Server。

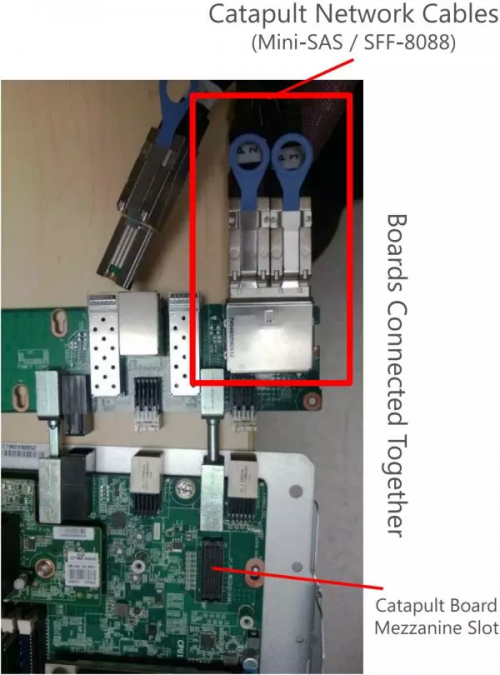

▲FPGA 与 Open Compute Server 之间的连接与固定。

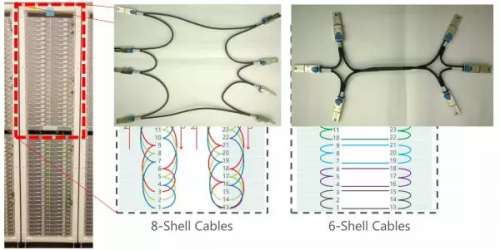

FPGA 采用 Stratix V D5,有 172K 个 ALM,2014 个 M20K 片上内存,1590 个 DSP。板上有一个 8GB DDR3-1333 内存,一个 PCIe Gen3 x8 接口,两个 10 Gbps 网络接口。一个机柜之间的 FPGA 采用专用网络连接,一组 10G 网口 8 个一组连成环,另一组 10G 网口 6 个一组连成环,不使用交换机。

▲机柜中 FPGA 之间的网络连接方式。

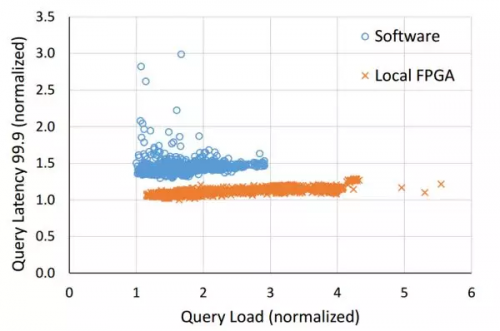

这样一个 1632 台服务器、1632 块 FPGA 的集群,把 Bing 的搜索结果排序整体性能提高到了 2 倍(换言之,节省了一半的服务器)。

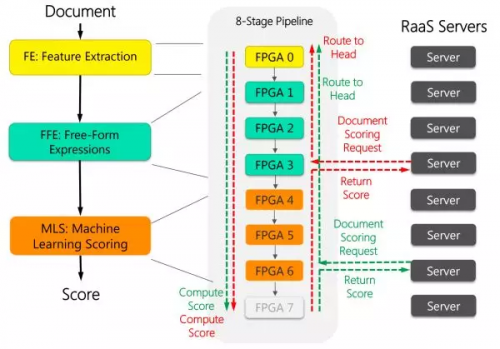

如下图所示,每 8 块 FPGA 穿成一条链,中间用前面提到的 10 Gbps 专用网线来通信。这 8 块 FPGA 各司其职,有的负责从文档中提取特征(黄色),有的负责计算特征表达式(绿色),有的负责计算文档的得分(红色)。

▲FPGA 加速 Bing 的搜索排序过程。

▲FPGA 不仅降低了 Bing 搜索的延迟,还显著提高了延迟的稳定性。

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码