基于多特征SVMs分类器的手语识别*

SVMs

SVMs的主要思想是建立一个超平面作为决策曲面,使得正例和反例之间的隔离边缘被最大化。对于二维线性可分情况,令 H为把两类训练样本没有错误地分开的分类线,H1,H2分别为过各类中离分类线最近的样本且平行于分类线的直线,它们之间的距离叫做分类间隔。所谓最优分类线就是要求分类线不但能将两类正确分开,而且使分类间隔最大。在高维空间,最优分类线就成为最优分类面[8,9]。

设线性可分样本集为(xi,yi)),i=1,2,…,n,x∈Rd,即x是d维特征向量,y∈{+1,-1}是类别标号,d维空间线性判断函数的一般形式为g(x)=w×x+b,分类面方程为:w×x+b=0 (1)

式中w为权向量,b为分类阈值。要求分类面对所有样本正确分类,就是要求它满足:

Yi[w×xi+b]-1≥0,i=1,2,…,n (2)

满足上述条件且使||w||2最小的分类面就叫做最优分类面, H1,H2上的训练样本点,也就是使式(2)中等号成立的样本点,称作支持向量。解这个最优化问题后得到的最优分类函数是:

![]()

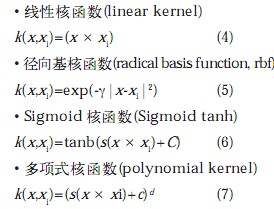

在学习样本是线性不可分,但却是非线性可分的情况下,可以通过非线性变换把学习样本变换到高维空间,使其在高维空间里是线性可分的。用核函数 K(x,y)代替原来的点积(x·y),Mercer定理指出,核函数 K(x,y)通过与其相联系的非线性变换Φ隐含地把特征向量映射到高维特征空间,使得学习样本成为线性可分的。常用的核函数有:

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码