MIMO分布式天线延时失衡性能分析

在目前的LTE室内商用系统的基本配置中,一般采用2×2天线配置。下行BS采用双天线分集或者复用发射,UE采用双天线接收。上行UE采用单天线发射,BS采用双天线接收,即接收分集。理论分析中,大多假设多天线阵列中各天线单元增益相同且时延相等。但在实际工程应用中,由于馈线及器件制造工艺的差异,会引入天线单元的增益与时延的差异。中国移动企业标准中,对于宏基站天线有明确的规定:各天线端口的幅度偏差≤0.7dB;相位偏差≤5°。

在实际的室内分布式天线系统中,由于馈线以及极化天线本身的差异会引入天线延时不平衡因素。文中将对基于LTE系统,分析分布式天线系统中延时失衡对LTE基带系统带来的影响,并评估其可行性。

1 延时分析模型

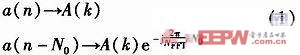

以LTE 20 MHz带宽系统分析:采样周期T=1/30.72MHz=0.032 6μs,对应于光速传播距离约为9.8 m。以10 MHz带宽分析:采样率为15.36 MHz,对应于光速传播距离为19.6 m。假设时域上采样点偏移N0,则相应在频域上的变换如式(1)所示。

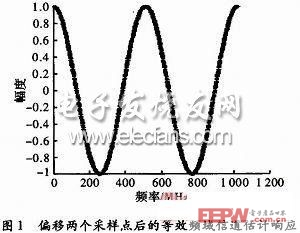

从式(1)可以看到,时域上线性偏移,频域上叠加线性相偏。时域上偏移越多,相偏变化越快。偏移两个采样点后,等效的频域信道估计响应如图1所示。

从图1可以看出,频域等效信道响应呈周期性变化;当信道偏移量扩大时,此变化周期变快;当变化周期快于频域信道估计周期时,系统性能将会恶化。LTE 下行帧结构中,采用每个RB在频域上包含14个子载波,中间插入两个Pilot,用于信道估计。Pilot中间位置则使用插值算法作估计。如果频域相偏变化过快,则会导致插值算法估计不准确,影响链路性能。

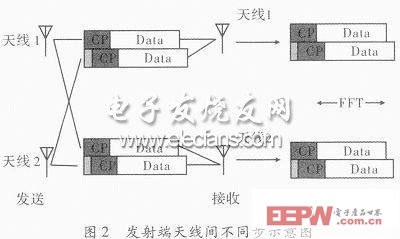

假设LTE 2×2 MIMO系统,发射天线存在不同步的情况如图2所示。

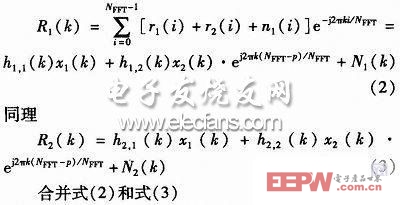

以接收端天线1为例,在FFT窗内对接收数据作变换,设r1(i),r2(i)分别为来自发送端天线1和天线2的:Data区域的时域信号抽样点,其中0≤i≤NFFT-1,并设r2(i)为接收端FFT窗内的时域信号抽样点,时延为p个抽样点。

由于下行DMRS并非在频域上连续分布,因此φ与k不一定相等,即由天线2时延造成的相位偏差不一定可以消除,从而造成接收端解调性能的下降。

2 仿真与分析

为验证延时失衡理论分析结果的正确性,文中在不同信道环境下,针对LTE典型业务进行仿真,并对结果进行分析比较。系统采用10MHz带宽,15.36 MHz采样。上行链路仿真参数:仿真信道采用LTE标准中EPA 5 Hz信道;仿真业务采用LTE标准的FRC A4-6;信道估计算法采用LS平均算法;天线配置为1×2 SIMO;接收合并采用最大比合并(MRC)算法。下行链路仿真参数:仿真信道采用EPA 5 Hz;仿真业务中块长5 736,调制方式为16QAM;信道估计采用LS线性插值;天线配置为2×2MIMO。发送模式:两天线不带CDD的空间复用。

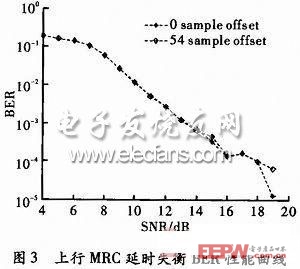

首先分析接收端由于两天线间上行延时不平衡,对系统造成的影响。分析高斯白噪声信道下,不同信噪比环境下,不同的延时差异条件下,系统性能的恶化情况。图3是AWGN信道下的BER仿真结果。

从图3中可以看出,上行由于LTE标准中频域插入的RS为全频段设置,接收机不需要进行频域插值,所以延时对接收机几乎没有影响。

另外,还分析了下行MIMO配置下,发射天线延时差异对系统性能的影响。在不同信噪比环境和不同延时差异条件下的性能对比。

3 结束语

MIMO室内分布式天线系统中,由于馈线以及极化天线本身的差异会引入延时不平衡因素。针对MIMO系统,首先从理论上分析分布式天线系统中延时失衡对MIMO系统带来的影响。通过仿真,定量分析了MIMO上下行链路中,延时失衡对基带性能的不利影响。结果表明:上行链路性能对延时差异不敏感;对下行链路,在时延差异达到0.5CP时,系统性能会有约2dB损失;当延时差异达到0.75CP时,性能下降达到8dB。

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码